由于每个企业具有不同类型,数量和格式的数据,并随着时间的推移而产生不同的业务需求,因此目前有许多不同的方法和工具用于集成数据。根据业务和技术,本文总结了几种主要类型的工具:

-

运用代码数据集成

-

ETL工具

-

API 工具

-

大数据企业平台

1、运用代码数据集成

只要掌握基本编程技能,业务人员就可以运用简单的脚本来获取集成数据。这个过程可以直接在数据库内完成,也可以部署到应用程序。代码是移动数据的快捷方式,它们可以按照预定义的时间表运行,也可以作为由事件触发的服务运行,或者在满足定义的条件时作出响应。他们可以从多个来源获取数据,在将数据传送到目标数据源之前加入,过滤,清理验证和转换数据。但要求开发人员预测数据集成和相应程序可能出现的问题。另外,开发自定义脚本在使用许多实验数据源时可能不具有成本效益。最后,数据集成脚本通常难以完成知识转移知识,并且需要专业开发人员进行维护。

2、ETL工具

ETL是英文Extract-Transform-Load 的缩写,用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目的端的过程。ETL负责将分布的、异构数据源中的数据如关系数据、平面数据文件等抽取到临时中间层后进行清洗、转换、集成,最后加载到数据仓库或数据集市中,成为联机分析处理、数据挖掘的基础。数据抽取,从数据源中抽取数据的过程。实际应用中,数据源较多采用的是关系数据库。数据转换,这一步包含了数据的清洗和转换。从数据源中抽取的数据不一定完全满足目的库的要求,例如数据格式的不一致、数据输入错误、数据不完整等等,因此有必要对抽取出的数据进行数据转换和加工。数据的转换和加工可以在ETL引擎中进行,也可以在数据抽取过程中利用关系数据库的特性同时进行。数据加载,将转换和加工后的数据装载到目的库中通常是ETL过程的最后步骤。转换作业生成的数据有可能直接插入目标数据库,一般来说,这种情况常见于使用数据库存储过程进行转换作业的方案。此时,ETL作业位于目标数据库上,加载作业只需要使用INSERT或者LOAD的方式导入目标表即可。

3、API工具

如果开发需要连接到多个数据源和API的Web或移动应用程序,则有API和应用程序开发工具可以简化这些集成。这些工具不是将数据集成到中央存储库中,而是提供各种选项,以便在使用多个API和数据源时支持更快的应用程序开发。应用程序集成有多种不同的平台类型和工具提供,旨在简化API和数据访问,并充当数据总线以集中交互。可以实现使用低代码和移动开发平台进行数据集成,并提供开发和开发环境,以快速构建和运行应用程序。

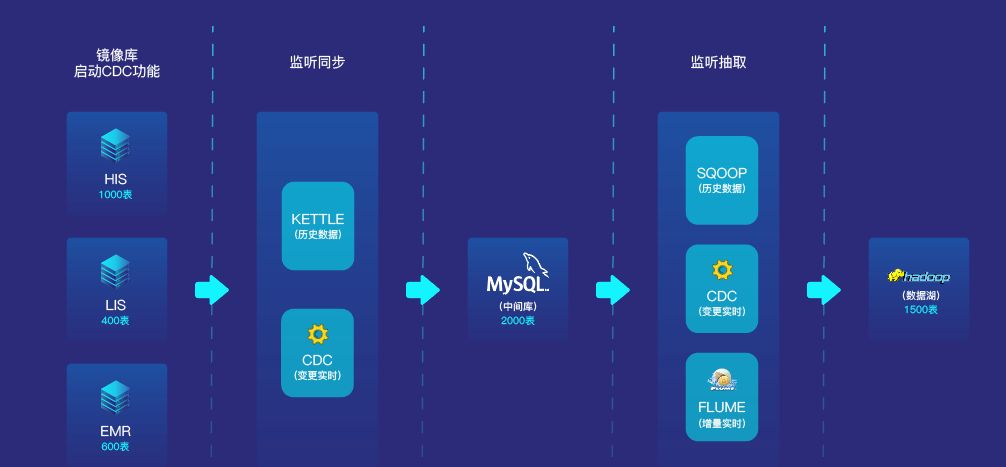

以亿信华辰睿治数据集成管理平台为例,基于开源Hadoop框架开发,融合MPP、SQL on Hadoop、流处理等大数据技术,支持海量数据的高效储存和集成。可实现跨部门数据的传输、加载、清洗、转换和整合,支持自定义调度和图形化监控,实现统一调度、统一监控,满足运维可视化需求,提高运维管理工作效率。该平台还可以融合数据集成、数据交换、实时计算存储、元数据管理、数据标准管理、数据质量管理、主数据管理、数据资产管理、数据安全管理、数据生命周期管理十大产品模块,打通数据治理各个环节,十大产品模块可独立或任意组合使用,快速满足政府、企业各类不同的数据治理场景。